1、数据结构分析和数据存储 爬虫需求要十分清晰,具体表现为需要哪些字段,这些字段可以是网页上现有的,也可以是根据网页上现有的字段进一步计算的,这些字段如何构建表,多张表如何连接等值得一提的是,确定字段环节,不要只看。

2、利用python写爬虫程序的方法1先分析网站内容,红色部分即是网站文章内容div2随便打开一个div来看,可以看到,蓝色部分除了一个文章标题以外没有什么有用的信息,而注意红色部分我勾画出的地方,可以知道,它是指向文章。

3、mport reimport requests def ShowCity html = requestsgetquotaspx?id=quot citys = refindall#39#39, htmltext, reS for city in citys。

4、良好的爬虫框架可以确保爬虫程序的稳定性,以及编写程序的便捷性所以,这个cspider爬虫库的使命在于,我们能够使用c语言,依然能够优雅地编写爬虫程序爬虫的特性 配置方便使用一句设置函数,即可定义user agent,cookie,time。

5、1对网页结构需要有一个基本的了解和认知我们平时上网浏览网页,信息展现在浏览器里面的页面中,但我们用爬虫要抓取的信息是放在网页源代码里面的图1为我们看到的页面,图2 为页面对应的网页源代码在浏览器中使用快捷。

6、下面说明知乎爬虫的源码和涉及主要技术点1程序package组织 2模拟登录爬虫主要技术点1要爬去需要登录的网站数据,模拟登录是必要可少的一步,而且往往是难点知乎爬虫的模拟登录可以做一个很好的案例要实现一。

7、php不太适合用来写网络爬虫,因为几乎没有现成的框架,或者成熟的下载机制,也不太适合做并发处理下载页面的话除了一个curl,就是file_get_contents,或者curl_multi来做并发请求curl可以代理端口,虚假ip,带cookie,带header请求。

8、在注解模式下,使用一个简单的Model对象加上注解,可以用极少的代码量就完成一个爬虫的编写注解模式的开发方式是这样的首先定义你需要抽取的数据,并编写Model类在类上写明@TargetUrl注解,定义对哪些URL进行下载和抽取。

9、个人以为应该先从一个URL入手将此URL内容抓至硬盘,再启动线程分析此URL内连接,遍历此连接,分别抓到硬盘 再用线程对硬盘上文件分别分析URL,看到新的就抓可能是这样吧。

10、使用 superagent 与 cheerio 完成简单爬虫目标 建立一个 lesson3 项目,在其中编写代码当在浏览器中访问。

11、先根据一个链接,抓取该页面解析该页面,搜取出该页面中有用的链接,根据链接地址循环抓取就OK了简单爬行器原理 抓取完文件后还需要一个功能好点的文档解析器来解析出文件中的内容文件解析器 再根据关键字分词。

12、你说说你都要什么功能啊,要是功能简单我就给你做,复杂你得给点钱。

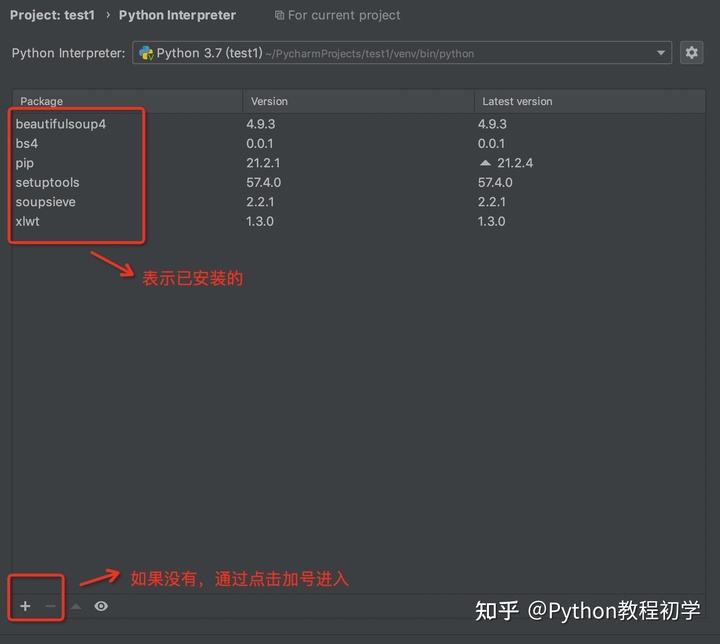

13、楼主你好,爬虫的作用是爬取指定的url页面信息,如果要按照你的要求进行输出信息,需要对爬取的页面进行解析,是另一个步骤,建议你搜索一下python中解析html页面的类库,我推荐beautifulsoup这个库,功能很强大。

14、mac用来写python爬虫可以Linux下运行Python程序,一般说来有以下两种形式,其实和Windows下基本一样一在IDLE中运行 在终端窗口输入 python进入交互式运行环境,然后就可以边输入边执行代码了 print #39Hello Python#39Hello。

15、在面向对象的高级语言中,早已有人将。

16、系统是根据cookie来判断用户的有了cookie就有了登录状态,以后的访问都是基于这个cookie对应的用户的补充Java是一种可以撰写跨平台应用软件的面向对象的程序设计语言Java技术具有卓越的通用性高效性平台移植性和安全。

17、首先,你要安装requests和BeautifulSoup4,然后执行如下代码importrequestsfrombs4importBeautifulSoupiurl=#39parser#39#标题H1=soupselect#39#artibodyTitle#390text#来源time_source=soupselect#39timesource#390text#。